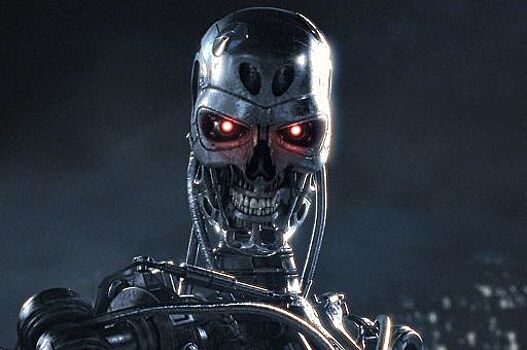

Стоит ли бояться восстания машин?

Когда искусственный интеллект начнет обучаться самостоятельно и будет ли он видеть смысл в людях. Рассказывает Сергей Марков, специалист по методам машинного обучения и лектор культурно-просветительского проекта АРХЭ. Стоит ли бояться восстания машин? Если отвечать коротко, то, на мой взгляд, нет. Но это не значит, что не существует рисков, связанных с развитием технологий искусственного интеллекта, которые требовали бы определенного внимания со стороны специалистов и общества. Если вы вдруг станете думать в сто раз быстрее, это не сделает вас в сто раз умнее Причин, по которым «восстание роботов» — крайне маловероятный сценарий, несколько. Приведу несколько из них. Во-первых, сценарии, подобные описанным в «Терминаторе» и других технопессимистических произведениях искусства предполагают, что дефектной системе искусственного интеллекта (ИИ) будет по какой-то причине вручен безраздельный контроль над разрушительным оружием. Если обезьяне дать ядерную красную кнопку, то она ведь может ее нажать? Значит ли это, что нам нужно опасаться восстания обезьян и предпринимать превентивные меры против них? Я думаю, что куда больше стоит опасаться того, что кнопку нажмут люди. Технологии становятся потенциально все более разрушительными, а вот наша способность грамотно применять эту силу вряд ли прогрессирует столь же быстро. Системы ИИ в данном случае это скорее не источник опасности, а способ, при помощи которого эту опасность можно будет снизить. Вторая причина: многие катастрофические сценарии основаны на том, что ИИ будущего будет сверхинтеллектом, превосходящим людей, возможно, даже больше, чем люди превосходят муравьев. Однако Вселенная содержит целый ряд фундаментальных физических ограничений, которые, по всей видимости, сделают создание сверхинтеллекта невозможным. Скорость передачи сигнала не может превысить скорости света, а на планковских масштабах появляется неопределённость Гейзенберга. Отсюда вытекает первый фундаментальный предел — предел Бремерманна, вводящий ограничения на максимальную скорость вычислений для автономной системы заданной массы m, не зависящий от ее физической реализации. Другой предел связан с принципом Ландауэра, в соответствии с которым при потере одного бита информации в системе выделяется некоторое минимальное количество теплоты. Слишком быстрые вычисления вызовут недопустимый разогрев и разрушение системы. В действительности, современные процессоры от лимита Ландауэра отделяет менее чем тысячекратное отставание. Казалось бы, 1000 — это довольно много, однако еще одна проблема заключается в том, что многие интеллектуальные задачи относятся к классу сложности EXPTIME. Это означает, что время, необходимое для их решения, является экспоненциальной функцией от размерности задачи. Ускорение системы в несколько раз дает лишь константный прирост «интеллекта». Грубо говоря, если вы вдруг станете думать в сто раз быстрее, это не сделает вас в сто раз умнее. Словом, есть серьезные основания полагать, что сверхинтеллектуального ИИ не получится, хотя, конечно, уровень человеческого интеллекта вполне может быть превзойден. Насколько это опасно? Скорее всего, не очень. Третья причина: для «захвата мира» создаваемая система ИИ должна на голову превосходить всех остальных интеллектуальных агентов — людей, другие ИИ. Хотя отдельные люди умнее других, никому из них пока что не удалось захватить власть над всем миром, то же самое будет, скорее всего, и системами ИИ. И, наконец, причина номер четыре: ИИ это, прежде всего, инструмент в руках людей, а цель любого инструмента — это усиление возможностей человека. По мере того, как развитие технологий позволит эффективно манипулировать с объектами, сопоставимыми по сложности с человеческим организмом, скорее всего, граница между человеческим телом и продуктом наших технологий будет постепенно стираться. На самом деле уже сегодня мы можем видеть первые ростки этого явления. Например, смартфон уже сегодня стал в некотором роде частью тела человека. Весь наш вид постоянно занимается тем, что меняет себя, вмешивается в собственную биологию самым решительным образом. Когда люди изобрели огонь, и стали варить на нем пищу, это привело к том, что стали выживать особи со слабо развитыми челюстями. Нам перестали быть нужны сильные челюсти, в черепе, объем которого определяет в том числе способностью ребенка пройти через родовые пути, высвободилось дополнительное место под мозг и, возможно, это стало одним из факторов развития интеллекта. Стало быть, мы генетически модифицировали себя при помощи технологии, пусть и такой примитивной, как варка пищи. Конечно, эта модификация не была прямой, мы изменили среду, в которой живем, а затем под её влиянием изменились сами. Но со временем мы создавали новые инструменты, позволяющие непосредственно вмешиваться в наш организм. Вы выпиваете таблетку аспирина и вмешиваетесь в биохимические пути вашего организма. Одежда заменяет шерсть, рычаг — сильные руки. В силу примитивности технологий, которые мы используем, между нашим телом и нашими инструментами пока ещё существует явно различимый барьер. Но если завтра можно будет безболезненно и без побочных эффектов установить смартфон прямо в голову, я думаю, что вряд ли мы будем долго раздумывать перед тем, как начнём применять эту технологию. Это ведь очень удобно: освободятся руки, можно будет получать картинку прямо перед глазами в любой момент. Поэтому, скорее всего, будущее всё-таки не за ИИ в чистом виде, а за синтетическим интеллектом, и уже сегодня активно развиваются технологии, благодаря которым завтра подобные мечты смогут стать реальностью. Сергей Марков, автор одной из сильнейших российских шахматных программ, специалист по методам машинного обучения и основатель портала XX2 век. Лектор культурно-просветительского проекта АРХЭ